راهنمای جامع، بهروز و کاربردی برای انسانها و کسبوکارها

در چند سال اخیر مدلهای زبانی بزرگ یا Large Language Models (LLM) تبدیل به قلب موتورهای هوشمند شدهاند؛ ابزارهایی که میتوانند متن را بفهمند، تحلیل کنند، بنویسند، خلاصه کنند، ترجمه تولید کنند و حتی به ما در تصمیمگیری کمک کنند.

این مدلها امروز در هر جایی حاضرند: از موتورهای جستجو گرفته تا ابزارهای خودکارسازی، چتباتهای سازمانی، سیستمهای توصیهگر و حتی ابزارهای آموزشی.

اما LLM دقیقاً چیست؟ چگونه کار میکند؟ چرا ناگهان کل دنیا روی آن متمرکز شده؟ و چطور میتوان از آن در مقیاس فردی یا سازمانی استفاده کرد؟

در این مقاله دقیقاً قرار است همهٔ اینها را گامبهگام و با زبانی ساده توضیح بدهیم.

مدل زبانی بزرگ نوعی مدل هوش مصنوعی است که برای درک و تولید زبان انسان طراحی شده.

وظیفهاش این است که الگوهای زبان، روابط میان کلمات، ساختار جملهها و معنای متن را یاد بگیرد.

به زبان ساده LLM مثل یک فرد بسیار کتابخوان است که میلیونها جمله خوانده و حالا میتواند خودش متن بسازد یا متن را تحلیل کند.

این مدلها روی مجموعه دادههای عظیم شامل:

آموزش داده میشوند و پس از آموزش، به یک "مغز" بزرگ زبانی تبدیل میشوند.

در قلب LLMها مفهومی به نام احتمالدهی به کلمهٔ بعدی وجود دارد.

یعنی مدل ابتدا یاد میگیرد که در یک جمله، احتمالاً چه کلمهای با چه ترتیبی میآید. این فرآیند بسیار پیچیدهتر از حد تصور است، اما ایدهٔ اصلی از همینجا شروع میشود.

به مرور زمان مدل میفهمد که:

و در نهایت تبدیل به یک سیستم قدرتمند زبانشناختی میشود.

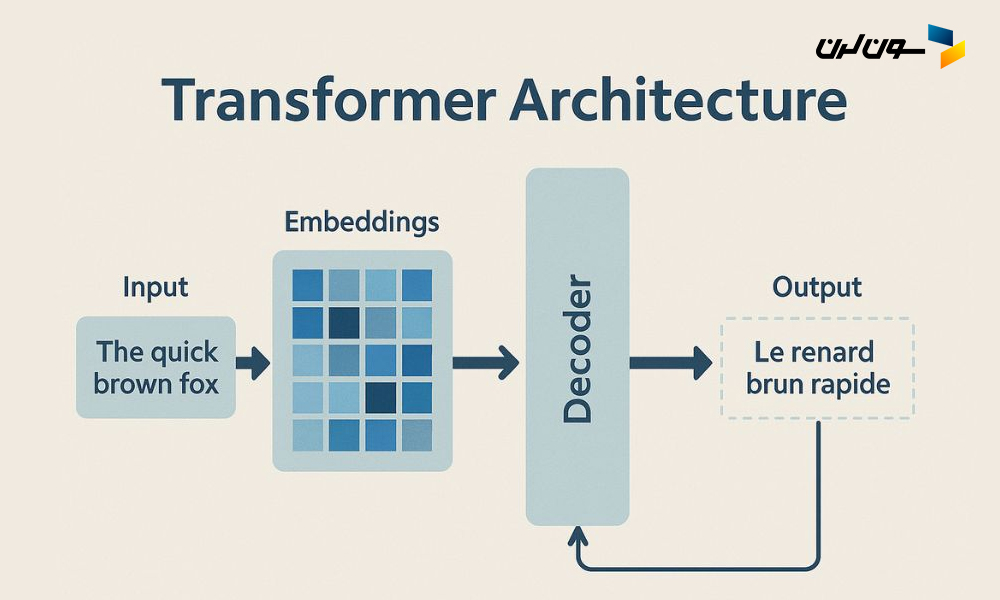

تقریباً همهٔ مدلهای زبانی مدرن بر پایهٔ معماری Transformer ساخته شدهاند. این معماری ابتدا در مقالهٔ معروف «Attention Is All You Need» معرفی شد.

چون به مدل اجازه میدهد:

در این معماری چیزی به نام Self-Attention باعث میشود مدل بفهمد که هر کلمه چه ارتباطی با سایر کلمات دارد. همین قابلیت اساس تولید متن روان، مفهومی و شبیه انسان است.

پارامترها واحدهای کوچک اطلاعاتی هستند که مدل هنگام آموزش آنها را «تنظیم» میکند. هر چه تعداد پارامترها بیشتر باشد، مدل ظرفیت بیشتری برای یادگیری دارد.

برای نمونه:

| مدل | تعداد پارامتر |

|---|---|

| GPT-2 | 1.5B |

| GPT-3 | 175B |

| Llama 3 | 70B |

| GPT-4 | تخمینی بیش از 1T |

| GPT-5 و GPT-5.1 | معماری ترکیبی + expert mixture + sparse routing |

پارامتر بالا لزومی به معنای بهتر بودن نیست اما ظرفیت یادگیری را بالا میبرد.

فرآیند یادگیری و پاسخدهی LLM در پنج گام اصلی خلاصه میشود:

۱. پیشآموزش (Pre-Training): مدل زبان عمومی را از میان حجم عظیمی از داده میآموزد. هدف: یادگیری زبان عمومی.

۲. ریزتنظیم (Fine-Tuning): برای وظایف خاص مثل ترجمه، کدنویسی، تحلیل داده و... آموزش میبیند.

۳. یادگیری با بازخورد انسانی (RLHF): رفتار مطلوب از نگاه انسان را میآموزد.

۴. پاسخدهی (Inference): با دریافت ورودی کاربر، بهترین خروجی را پیشبینی میکند.

۵. کنترل کیفیت: لایههایی مانند RAG و Safety Filters خروجی را پالایش میکنند.

مدلهای زبانی امروز در همهٔ صنعتها کاربرد دارند. چند مثال:

سیستمهای RAG (Retrieval Augmented Generation) یک لایه فوقالعاده روی LLM هستند.

RAG به مدل اجازه میدهد به جای اینکه فقط روی حافظهٔ خودش تکیه کند، از دانش واقعی، بهروز و اختصاصی استفاده کند.

مثلاً در سازمانها:

در Vector Store ذخیره میشوند و مدل هنگام پاسخدهی آنها را واکشی میکند.

LLMها قدرت زیادی دارند، اما محدودیتهایی هم دارند:

جهتگیری آیندهٔ LLMها کاملاً مشخص است:

به زبان ساده: مدلها نه تنها «رشد» میکنند، بلکه «خودکار»، «پرکاربردتر» و «ارزانتر» میشوند.

مدلهای زبانی بزرگ یکی از بنیادیترین فناوریهای عصر حاضر هستند.

این مدلها به ما اجازه میدهند:

و حتی سیستمهایی بسازیم که بهصورت مستقل کارهای پیچیده را برای ما انجام میدهند.

اگر بخواهیم دنیای جدید را بهتر بفهمیم، LLM فقط یک ابزار نیست— یک زیربنای آیندهٔ نرمافزار و کسبوکار است.

اصفهان، خیابان حمزه اصفهانی، بن بست تخت جمشید(18) ، پلاک ۴

دفتر تهران: تهران، خیابان سهروردی شمالی، خیابان هویزه شرقی، پلاک 20، طبقه دوم، واحد 6